论文链接:

背景

残差神经网络(ResNet)是由微软研究院的何恺明、张祥雨、任少卿、孙剑等人提出的。ResNet 在2015 年的ILSVRC(ImageNet Large Scale Visual Recognition Challenge)中取得了冠军。

残差神经网络的主要贡献是发现了“退化现象(Degradation)”,并针对退化现象发明了 “快捷连接(Shortcut connection)”,极大的消除了深度过大的神经网络训练困难问题。神经网络的“深度”首次突破了100层、最大的神经网络甚至超过了1000层。

粗读

摘要

提出问题,深层神经网络难以训练(过拟合和训练误差、梯度爆炸和梯度消失)。我们做出的贡献,使用残差来训练很深的神经网络。

图表

介绍了一些层数的神经网络使用残差链接和不使用的对比效果。

精读

导论

residual解决了什么问题。

好的文章不一定是提出了什么新的东西,也可以是将之前的一些研究成果巧妙地结合起来,解决了一个现实中大家比较关心的难的重要的问题。

介绍

过拟合的问题:训练误差变得很低,而测试误差变得比较大

当网络变得很深的时候出现的问题:训练误差和测试误差都变得很大,网络虽然是收敛的,但是没有达到一个很好的效果

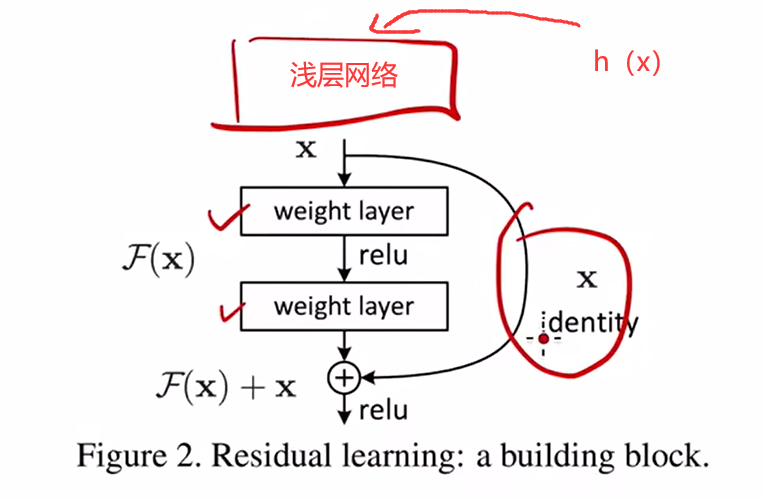

identity mapping:解决浅层网络堆叠成深的网络之后,效果变差的问题。(deep residual learning framework.深度剩余学习框架)

残差学习:新加的层不再继续学习h(x),而是学习f(x)=h(x)-x【原始输入h(x)与原始输出x之间的差别】,最终的输出是f(x)+x【浅层学到的东西和深层从残差中学到的东西】

相关工作

对研究者来讲,对于之前的工作和文章,应用到现在的场景中,相同的问题,数据量更大,计算能力更强会形成新的挑战,旧的技术也有新的应用和新的意义

实验

确定了一些参数和超参数。

参数 :就是模型可以根据数据可以自动学习出的变量,应该就是参数。 比如,深度学习的权重,偏差等

超参数 :就是用来确定模型的一些参数。超参数一般就是根据经验确定的变量。 在深度学习中,

超参数有:学习速率,迭代次数,层数,每层神经元的个数等等。

图表很重要,大量的文字都是在介绍图和表,如果能看懂图表的话,就可以知道作者在做什么,达到了什么样的效果,可以忽略文字描述。

总结

随机梯度下降(stochastic gradient descent,SGD)

精髓:人生如SGD,要一直有梯度,没有梯度就跑不动,就会停止。保证梯度一直够大,要一直能跑,慢慢总会收敛的。

算法:从样本中随机抽出一组,训练后按梯度更新一次,然后再抽取一组,再更新一次,在样本量及其大的情况下,可能不用训练完所有的样本就可以获得一个损失值在可接受范围之内的模型了。(这里的随机是指每次迭代过程中,样本都要被随机打乱,这个也很容易理解,打乱是有效减小样本之间造成的参数更新抵消问题。)